En el mundo de la Inteligencia artificial existe un campo especialmente competitivo en el que los grandes gigantes tecnológicos como Google y Amazon invierten mucho dinero y desean encontrar el santo grial.

Estamos hablando del campo del Natural Language Processing (Procesamiento natural del lenguaje). Este campo de la IA lo que busca es que un humano pueda mantener una conversación fluida con una inteligencia artificial de tal manera que el humano no sea capaz de diferenciar que con quién está hablando es con una máquina, es decir, lo que se pretende es poder comunicarte con una máquina de una manera perfectamente humana.

Todos conocemos los modelos cutres de ChatBots como Cleverbot o los famosos asistentes de empresas como Apple, Google o Amazon.

En todos estos casos, se usa la inteligencia artificial de una forma directa o indirecta para tomar decisiones respecto a la “conversación” que estamos teniendo. Pero todos sabemos que actualmente tienen poca fidelidad real y están muy muy incompletos. Esto lo notamos en cosas como que no son capaces de recordar partes anteriores de la conversación y por ende responder en consecuencia del hilo de la conversación. Sencillamente, son muy estúpidos a la

hora de la verdad.

Ahora bien, ¿Existe algún modelo de IA capaz de superar el test de Turing

actualmente?.

Podemos afirmar a medias tintas que esto está cambiando y actualmente tenemos un

aspirante claro.

GPT-3

GPT-3 es un modelo de Deep Learning enfocado al Natural Language Processing creado por la empresa Open AI.

GPT-3 actualmente es la Inteligencia artificial más próxima a marcar este hito, es posible que muchos no hayáis oído hablar de este modelo, pero en él se pueden conseguir conversaciones impresionantes que confundirían a cualquier humano.

Bueno, no es un modelo entrenado expresamente para mantener conversaciones, su potencial excede este hito, es literalmente un generador de texto capaz de continuar escribiendo cualquier texto que se le pase como input, es decir:

Si le pasas una conversación escrita hablándole directamente él te responderá personalmente manteniendo una conversación extremadamente realista de “tú a tú”.

Si le pasas el primer párrafo del Quijote, el continuará la historia de la forma que a él le parezca mejor, inventando y procesando a tiempo real los párrafos.

Si le introduces un párrafo de un noticiario sobre política o economía, él es capaz de mantener un hilo descriptivo completamente coherente con la noticia que se le ha pasado, incluso involucrando las nociones del mundo real, es capaz de reconocer quién es un personaje público, una empresa, una persona y actuar en consecuencia.

Este es un modelo de Deep Learning contempla la friolera de 175.000.000.000 parámetros en su red neuronal, esto es una barbaridad de parámetros a tener en cuenta al alcance de la capacidad de cómputo de pocos súper ordenadores en el mundo, por eso el modelo solo ha sido entrenado una vez en un súper ordenador teniendo como Dataset (set de datos) todas las páginas conocidas en internet, no hay datos específicos de si se ha entrenado con alguna clase de filtro de fiabilidad de las webs que escaneaba, por lo tanto, es posible que las Fake news y demás morralla de la web puedan influir negativamente en su percepción del mundo.

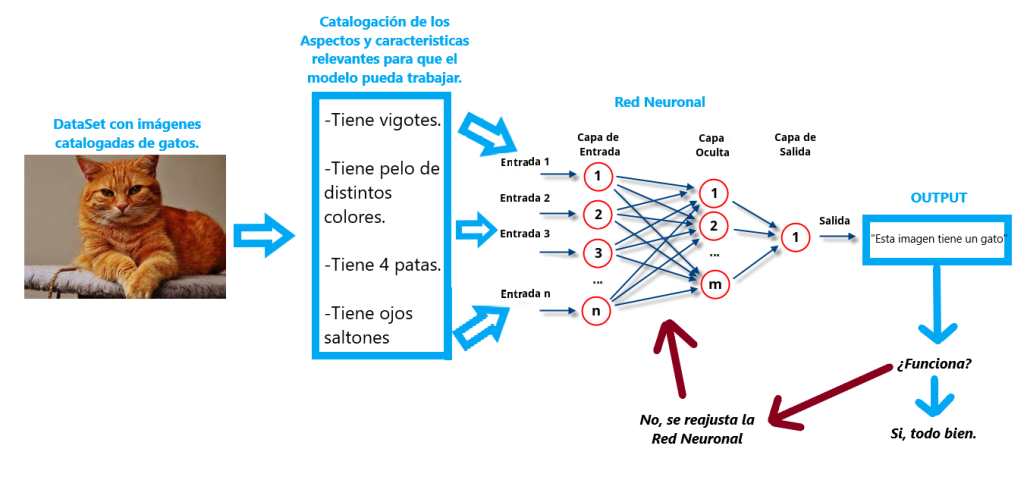

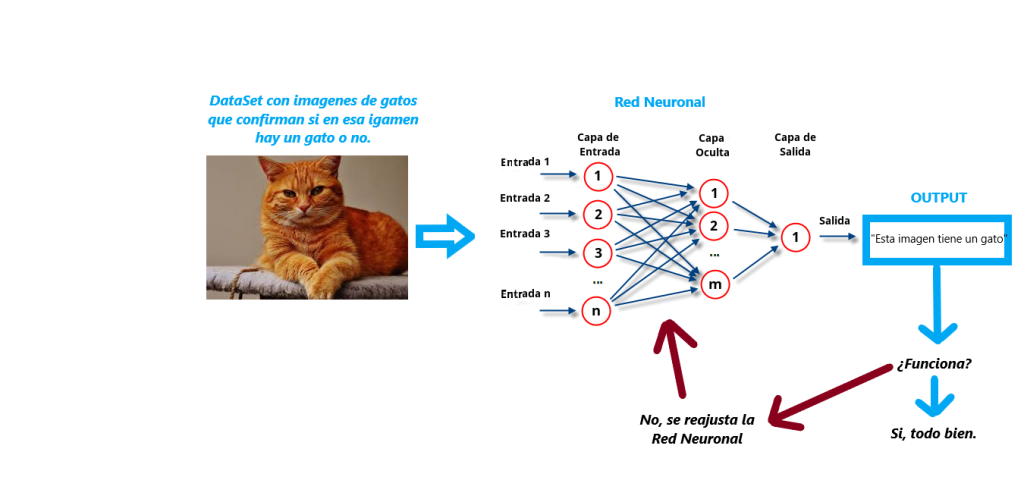

Si se quiere conocer más sobre cómo funcionan las Redes neuronales o que es el Deep Learning, hablamos sobre estos términos en nuestro último post: DEEP LEARNING, MACHINE LEARNING Y ¿QUÉ SON LAS REDES NEURONALES? .

Por desgracia la versión funcional de pruebas es una Beta privada al alcance de poca gente actualmente, por eso dejo un vídeo en español del canal de Youtube Dot CSV que consiguió acceso a la API privada y estuvo experimentando con ella.

Hay que tener en cuenta que el futuro estará lleno de robots que incorporarán estas tecnologías, por eso considero necesario conocer un poco como funcionan y como son entrenadas para adquirir el conocimiento necesario para funcionar. Quién sabe, tal vez el día de mañana tu tostadora incorpore el modelo GPT-3 y te cuente un cuento a la hora de irte adormir.

Bromas aparte, estas tecnologías tendrán fuertes implicaciones morales el día de mañana, porque ya son una realidad y esto solo puede suponer el comienzo de la nueva era tecnológica.

Exploraremos estas implicaciones filosóficas y morales en futuros post. Gracias por leernos.